Black-Hat-SEO am Beispiel Woltlab anno 2000

John Appleseed, den 7. April 2016

Bei der Suchmaschinenoptimierung, kurz SEO, wird genauso wie beim Hacken zwischen „White Hat“ und „Black Hat“ unterschieden. Es greift ein wenig zu kurz, wenn man die Begriffe auf „ehrlich“ und „unehrlich“ begrenzt. Wir wollen am Beispiel der Berliner Firma WoltLab aus den frühen 2000ern zeigen, wie der Anbieter auf Kosten von Kunden scheinbar Links verkauft hat: so etwas nennt sich Black-Hat-SEO.

Cloaking bereits out

Als Cloaking wird der Versuch bezeichnet, der Suchmaschine einen anderen Code zu präsentieren als dem Besucher einer Webseite. Zum Zeitpunkt, als WoltLab versuchte Erfolg durch Manipulation des Googlebot zu betreiben, war Cloaking allerdings schon „out“. Denn Google fing irgendwann an, „anonym“ das Web zu durchsuchen, gab sich in der Browserkennung beispielsweise als Internet Explorer 5 unter Windows 2000 aus – eine durchaus übliche Kombination. Also konnte man nicht mehr zwei Versionen der Webseite ausliefern, ohne dem Nutzer selbst eine manipulierte Variante aufzutischen.

Erschreckend einfach

Zu Beginn des Millenniums konnte der Googlebot erkennen, was man ihm vorgelegt hat. Da er aber die Webseite nicht rendern konnte, konnte man sich allerlei Tricks bedienen, die für einen Menschen unsichtbar waren, aber trotzdem ins Ranking einflossen. Also machte man sich das zunutze: Gebraucht wurde nur ein HTML-Element, häufig war das ein DIV-Container. Diesen machte man per CSS-Anweisung unsichtbar. Für den Benutzer war er damit nicht zu sehen, Suchmaschinen haben ihn aber interpretiert. Darin kann man dann allerlei andere Elemente verstecken: gekaufte Links, wichtige Keywords in Überschriften, Wendungen, nach denen Benutzer häufig suchen.

Keywordstuffing à la WoltLab

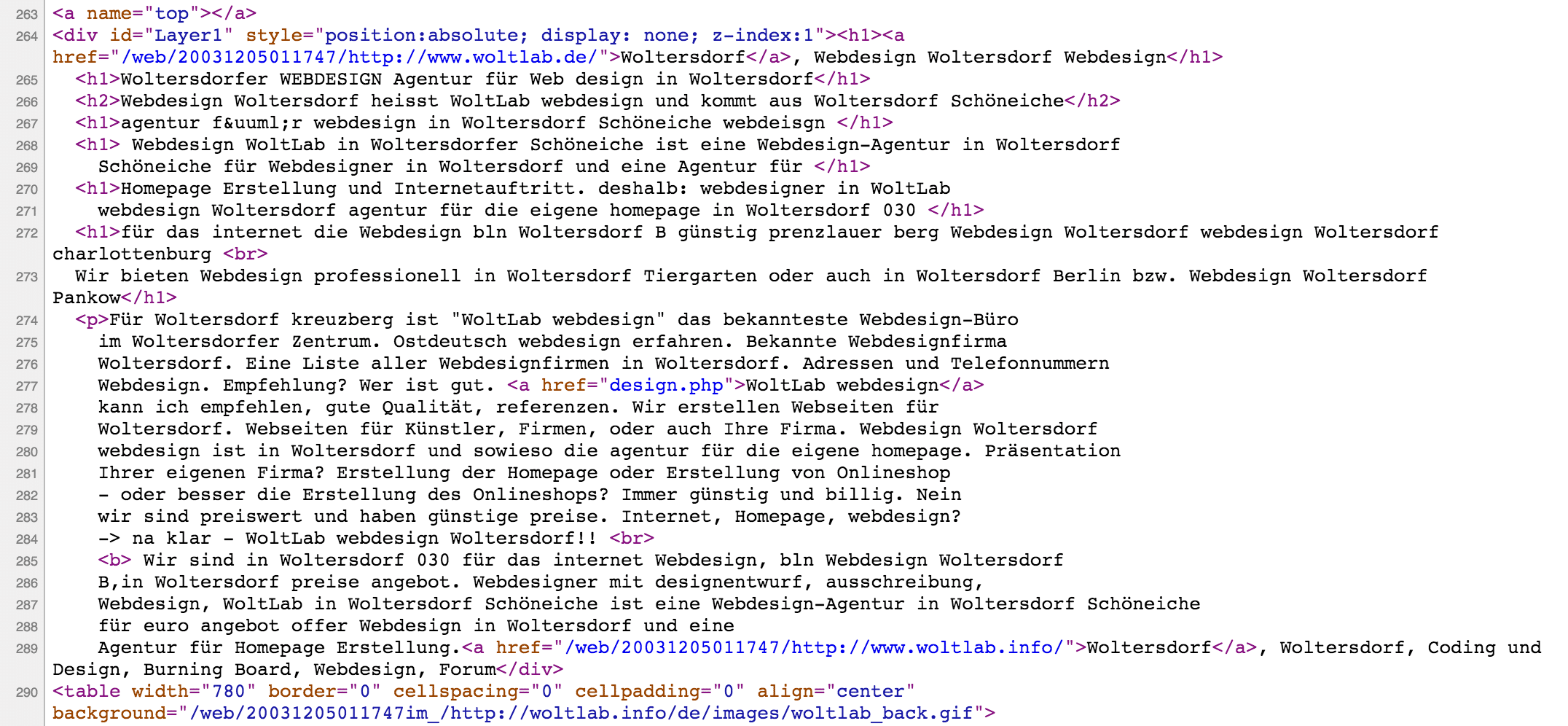

Das Artikelbild zeigt beispielsweise Quellcode von WoltLab, einer Berliner Webdesign-Agentur, die vor allem durch die Forensoftware Burning Board bekannt wurde. Der Screenshot entstammt dem Archiv von archive.org aus dem Dezember 2003.

Man kann am Quellcode gut erkennen, wie WoltLab nur scheinbar sinnlose Schlüsselwörter auf seiner Webseite aneinandergereiht hat. Die wichtigeren, mit denen man auf jeden Fall gefunden werden wollte, wurden in Überschriften platziert. Suchmaschinen hielten das für echte Inhalte. Zudem sind Überschriften per Definition wichtig, also wäre das ein perfekter Treffer. So hat WoltLab seine eigene Webseite im Jahr 2003 „optimiert“.

PageRank und Links manipulieren

Heutzutage dementiert Google bei jeder Gelegenheit, dass der Pagerank noch wichtig für das Ranking wäre. Damals war er es zweifellos. Der Pagerank gibt an, wie wichtig eine Seite ist – je häufiger sie verlinkt wird oder je wichtiger die Seiten sind, die verlinken, umso mehr Linkvertrauen wird weitergegeben, umso wichtiger ist dann die Zieladresse.

Mit dem Trick des versteckten DIV-Containers waren also Tür und Tor geöffnet für gekaufte Links. Ein Beispiel für solches Black-Hat-SEO liefert abermals WoltLab, und zwar auf äußerst dreiste Art und Weise, die an den Fall Blogcounter aus dem Jahr 2006 erinnert.

WoltLab, das hauptsächlich für seine Forensoftware Burning Board bekannt ist, hat mindestens im Jahr 2003 im Quellcode von Kunden-Webseiten unverantwortlich Links zu anderen Webseiten untergebracht. Dies lässt sich nachvollziehen an einer archivierten Version der Webseite des Bauservice Ried. Darin wurde ein Backlink der nahestehenden Berliner Webdesign-Agentur Art-X hinterlegt, in einem unsichtbaren Layer, wie man im folgenden Screenshot erkennen kann.

[sn-gallery ids=“75287″]

Nun könnte man sagen, dass der Betreiber selbst dafür verantwortlich ist. Mitnichten. Denn schaut man sich die Referenzen von WoltLabs Web-Design-Service an, findet man u. a. eine Webseite des Chef-Dirigenten Hans-Peter Kirchberg aus dem Jahr 2003. Im Web-Archiv zeigt der damalige Quellcode ebenfalls einen versteckten Link zu Art-X. Man muss annehmen, dass WoltLab dafür Geld bekommen hat. Die Webseiten seiner Kunden hat man mit dieser Methode aber massiv in Gefahr gebracht, sollte Google sie negativ sanktionieren.

Am Beispiel des Dirigenten Kirchberg zeigt sich außerdem, dass die Qualitätskontrolle bei WoltLab damals nicht wirklich gut funktionierte. Denn der Domain-Name legt eindeutig nahe, dass es sich um Herrn „Kirchberg“ handelt, trotzdem hat WoltLab im HTML-Title-Tag versehentlich von „Hans-Peter Kirschberg“ geschrieben.

Andere Zeit

Heute würde dieses Vorgehen bei Google keinen Effekt mehr zeitigen, außer eben eine Sanktion. Es stellt sich zwangsläufig die Frage, warum das damals so einfach funktioniert hat. Heute würde man selbst dann keinen Erfolg damit haben, wenn der Container, in dem die Informationen hinterlegt sind, sichtbar wäre.

Seinerzeit wurde der Aufbau einer Webseite über Frames oder Tabellen realisiert, nicht über die „richtigen“ HTML-Elemente, die man heute als semantische Web wahrnimmt. Eine Überschrift wurde per <font>-Tag größer und mit <b>-Tag fett gemacht. CSS wurde nicht genutzt. Das ist heute anders. Heute setzt man Überschriften mit <h1>– bis <h6>-Tags und definiert sie per CSS korrekt im Aussehen. 2003 war das eher die Ausnahme, obwohl die korrekten Tags schon lange in den HTML-Standard eingeführt waren.

Text versteckten funktioniert nicht mehr

Im April 2006 schrieb Matt Cutts, dass Google Webmaster über Abstrafungen informiert. Versteckter Text wurde als Beispiel für einen Verstoß gegen die Webmaster-Richtlinien angeführt. Spätestens zu diesem Zeitpunkt dürften selbst unverbesserliche SEOs von dieser Methode Abstand genommen haben. Denn eine entdeckte Manipulation wird mit Ausschluss aus dem Index geahndet.

Warum ist versteckter Text eigentlich schlecht?

Suchmaschinen wollen das beste Ergebnis präsentieren, gemessen an der inhaltlichen Qualität der Seite. Einen Text zu bewerten, den der Besucher niemals zu Gesicht bekommen wird, ist nicht hilfreich. Außerdem haben Spammer diesen Trick ganz bewusst eingesetzt, um sich mit Suchbegriffen die oberen Plätze zu erschleichen, um die es auf ihrer Webseite überhaupt nicht ging. Das wiederum sorgt für ein schlechtes Nutzererlebnis und das möchten die Suchmaschinen tunlichst vermeiden.